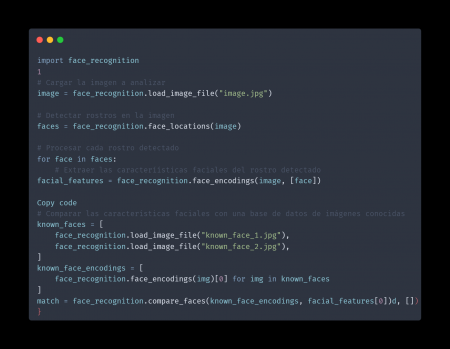

El reconocimiento de imágenes es una de las áreas de la inteligencia artificial (IA) que ha experimentado un gran avance en los últimos años. La capacidad de la IA para comprender y analizar imágenes se ha utilizado en una variedad de aplicaciones, desde la seguridad hasta el marketing y la medicina. Python es un lenguaje de programación popular para el desarrollo de aplicaciones de IA y el reconocimiento de imágenes no es la excepción. TensorFlow, una biblioteca de aprendizaje automático desarrollada por Google, es una herramienta popular para el desarrollo de modelos de IA en Python. En este artículo se discutirá cómo el reconocimiento de imágenes se logra mediante el uso de Python y TensorFlow.

El proceso de reconocimiento de imágenes se divide en dos etapas principales: aprendizaje automático y reconocimiento. En la primera etapa, se utiliza un conjunto de imágenes etiquetadas para entrenar un modelo de aprendizaje automático. Este modelo es entonces utilizado para reconocer objetos, rostros, escritura, etc. en imágenes no etiquetadas.

TensorFlow es una biblioteca de aprendizaje automático que se utiliza para crear modelos de IA en Python. Una de las ventajas de TensorFlow es que es fácil de usar y tiene una gran variedad de funciones para el procesamiento de imágenes.

Para ilustrar cómo se utiliza TensorFlow para el reconocimiento de imágenes, vamos a construir un ejemplo de una red neuronal para el reconocimiento de números escritos a mano. En primer lugar, se necesitará un conjunto de datos de entrenamiento que contenga imágenes de números escritos a mano etiquetadas con el número correspondiente. Un ejemplo de un conjunto de datos popular para este propósito es el conjuntode datos MNIST, que contiene imágenes de números escritos a mano etiquetadas con el número correspondiente.

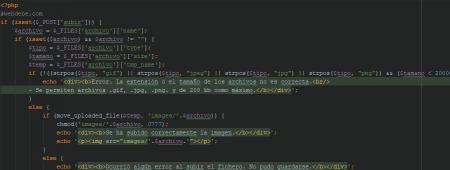

Una vez que se tiene el conjunto de datos de entrenamiento, se puede comenzar a construir el modelo de red neuronal en TensorFlow. El primer paso es importar las bibliotecas necesarias y cargar el conjunto de datos:

import tensorflow as tf mnist = tf.keras.datasets.mnist

A continuación, se dividirá el conjunto de datos en dos conjuntos: uno para entrenamiento y otro para pruebas. También se normalizarán las imágenes para que los valores de los píxeles estén en un rango de 0 a 1:

(x_train, y_train), (x_test, y_test) = mnist.load_data() x_train, x_test = x_train / 255.0, x_test / 255.0

Una vez que se tiene el conjunto de datos preparado, se puede comenzar a construir el modelo de red neuronal. En este ejemplo, se utilizará una red neuronal simple con dos capas ocultas. La primera capa es una capa de "flatten" que convierte la imagen de dos dimensiones a un vector de una dimensión. La segunda y tercera capa son capas densas (o completamente conectadas) con 128 y 10 neuronas respectivamente. La última capa es una capa de salida con 10 neuronas, una para cada número del 0 al 9:

model = tf.keras.models.Sequential([ tf.keras.layers.Flatten(input_shape=(28, 28)), tf.keras.layers.Dense(128, activation='relu'), tf.keras.layers.Dropout(0.2), tf.keras.layers.Dense(10, activation='softmax') ])

Una vez que se tiene el modelo construido, se puede comenzar a entrenarlo utilizando el conjunto de datos de entrenamiento y una función de pérdida (loss function) y optimizador adecuados. En este ejemplo, se utilizará la función de pérdida "sparse_categorical_crossentropy" y el optimizador "Adam":

model.compile(optimizer='adam', loss='sparse_categorical_crossentropy', metrics=['accuracy']) model.fit(x_train, y_train, epochs=5)

Una vez entrenado el modelo, se puede utilizar para hacer predicciones en el conjunto de datos de prueba. Se pueden ver las métricas deprecisión del modelo comparando las predicciones con las etiquetas reales del conjunto de datos de prueba:

test_loss, test_acc = model.evaluate(x_test, y_test)

print('Test accuracy:', test_acc)

Con este ejemplo se puede ver cómo es sencillo utilizar TensorFlow para construir y entrenar un modelo de red neuronal para el reconocimiento de imágenes. Sin embargo, es importante tener en cuenta que este ejemplo es solo un punto de partida para el desarrollo de aplicaciones más complejas. Es posible mejorar el rendimiento del modelo utilizando técnicas avanzadas de aprendizaje automático como el uso de capas convolutional, pooling y regularización, así como el uso de conjuntos de datos más grandes y complejos.